Les principes de la régularisation des données

Les principes de la régularisation des données sont essentiels pour assurer la qualité et la fiabilité des données utilisées dans divers processus d’analyse et de modélisation. La régularisation des données vise à minimiser les risques liés aux incohérences, erreurs ou valeurs aberrantes présentes dans les ensembles de données, ce qui peut compromettre la précision des résultats obtenus. Pour ce faire, plusieurs principes fondamentaux doivent être pris en compte lors de la régularisation des données.

Tout d’abord, il est crucial d’évaluer et de comprendre la nature des données à régulariser. Cela implique une analyse approfondie des sources de données, des méthodes de collecte et des éventuelles distorsions ou biais pouvant affecter la qualité des données. Ensuite, il est important de définir clairement les critères de régularisation en fonction des besoins spécifiques du domaine d’application, en se basant sur des normes et des bonnes pratiques de référence.

Par ailleurs, la mise en place de protocoles de validation et de vérification régulière des données est un autre principe clé de la régularisation. Cela implique la création de procédures de contrôle qualité pour détecter et corriger les éventuelles anomalies ou incohérences au sein des données. De plus, l’utilisation de techniques de normalisation, de filtrage et d’imputation peut contribuer à améliorer la consistance et la fiabilité des données, tout en réduisant les risques liés aux erreurs.

Enfin, la sensibilisation et la formation des acteurs impliqués dans la gestion et l’utilisation des données sont essentielles pour garantir une démarche cohérente de régularisation des données. Cela implique la promotion d’une culture de qualité des données, la mise en place de bonnes pratiques et la sensibilisation aux enjeux liés à la régularisation des données.

Méthodes de régularisation pour l’analyse des données

Les bases de la régularisation des données sont d’une importance cruciale dans l’analyse des données. Lorsqu’on travaille avec des ensembles de données complexes et bruités, il est souvent nécessaire de recourir à des méthodes de régularisation pour améliorer la précision et la généralisation des modèles d’analyse.

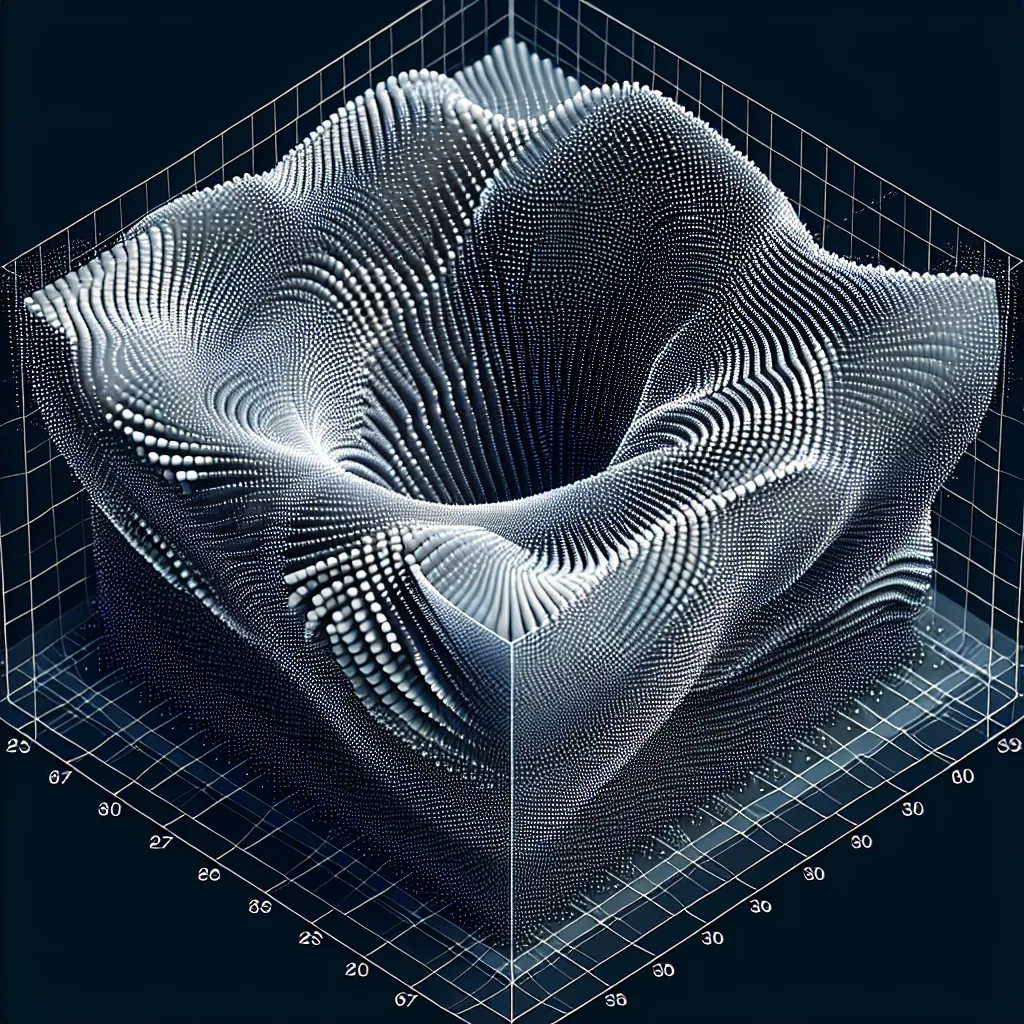

Les méthodes de régularisation pour l’analyse des données comprennent plusieurs approches, notamment la régression Ridge, la régression LASSO et l’élastic net. La régression Ridge vise à pénaliser les coefficients de régression en ajoutant une pénalité de norme L2 à la fonction de coût, ce qui permet de réduire la variance du modèle. De même, la régression LASSO utilise une pénalité de norme L1 pour sélectionner les variables importantes tout en réduisant les coefficients des variables moins significatives à zéro.

L’élastic net combine à la fois les pénalités L1 et L2 pour bénéficier des avantages des deux approches, offrant ainsi une meilleure flexibilité dans la sélection des variables. Ces méthodes de régularisation sont essentielles pour gérer le surajustement, améliorer la stabilité des modèles et sélectionner les variables pertinentes dans un ensemble de données.

En conclusion, les méthodes de régularisation pour l’analyse des données jouent un rôle crucial dans la construction de modèles robustes et précis. En comprenant et en utilisant ces approches de manière appropriée, les analystes de données peuvent améliorer la qualité de leurs modèles et obtenir des résultats plus fiables dans leurs analyses.

Les bases de la régularisation des données sont essentielles dans l’analyse des données, et les méthodes de régularisation telles que la régression Ridge, la régression LASSO et l’élastic net offrent des outils puissants pour améliorer la précision et la généralisation des modèles d’analyse. En comprenant et en utilisant ces techniques de manière appropriée, les analystes de données peuvent améliorer la qualité de leurs modèles et obtenir des résultats plus fiables dans leurs analyses.

Avantages de la régularisation dans le traitement des données

La régularisation des données est un processus essentiel dans le traitement des données qui offre de nombreux avantages pour améliorer la qualité des modèles d’apprentissage automatique. L’un des principaux avantages de la régularisation est sa capacité à réduire le surajustement (overfitting) des modèles. En introduisant des termes de régularisation dans la fonction de perte, on peut limiter la complexité des modèles et ainsi éviter qu’ils s’adaptent trop étroitement aux données d’entraînement, ce qui les rend plus généralisables aux nouvelles données.

Un autre avantage important de la régularisation est sa capacité à gérer les problèmes de colinéarité entre les caractéristiques (features) des données. En utilisant des méthodes de régularisation telles que la régularisation L1 ou L2, il est possible de réduire la dépendance entre les caractéristiques, ce qui peut conduire à des modèles plus stables et interprétables.

De plus, la régularisation peut aider à surmonter les problèmes de données manquantes et de valeurs aberrantes en réduisant leur impact sur les résultats du modèle. En incluant des termes de régularisation dans la fonction de perte, on peut atténuer l’effet des données non fiables ou extrêmes, ce qui contribue à des prédictions plus robustes et fiables.

En résumé, la régularisation des données offre une approche efficace pour améliorer la performance et la stabilité des modèles d’apprentissage automatique, en réduisant le surajustement, en gérant la colinéarité et en atténuant l’impact des données non fiables. C’est donc un outil puissant et largement utilisé dans le domaine de l’analyse de données et de l’apprentissage automatique.

L’importance de la régularisation des données dans l’apprentissage automatique

La régularisation des données est un concept important dans le domaine de l’apprentissage automatique. Elle vise à limiter le surajustement des modèles aux données d’entraînement, ce qui permet d’améliorer les performances des modèles lorsqu’ils sont confrontés à de nouvelles données. L’importance de la régularisation des données réside dans sa capacité à réduire la variance et à améliorer la capacité de généralisation des modèles.

En utilisant des techniques de régularisation telles que la régularisation L1, L2 ou la régularisation de type ElasticNet, il est possible de contrôler la complexité des modèles et d’éviter les cas de surajustement. Cela est particulièrement crucial dans des domaines tels que la prédiction de séries temporelles, la reconnaissance d’images et le traitement du langage naturel, où les données peuvent être complexes et comporter un grand nombre de variables.

Grâce à la régularisation des données, les modèles peuvent être entraînés de manière plus robuste, ce qui se traduit par des performances plus fiables lors de la prédiction de nouvelles observations. En fin de compte, l’application adéquate de la régularisation des données est essentielle pour garantir la validité et la précision des modèles d’apprentissage automatique.